耐久以来,开源多模态模子在复杂推理任务上,永远与 GPT-4o、Gemini 等顶尖闭源模子存在一齐难以逾越的范围。

社区诞生者们缓缓意志到,核肉痛点大致不在于模子架构的精进或者模子参数的限制。信得过的瓶颈,在于高质地、念念维链(CoT)密集的推理数据十分匮乏。

在纯文武艺域,DeepSeek-R1 的得胜已考证了高质地后锻真金不怕火数据(Post-training Data)的威力,但在多模态领域,咱们濒临的是横亘在咫尺的「两座大山」:

数据失衡:现存开源多模态数据仍以苟简 VQA 与当然图像为主,而关于信得过具有高推理价值的数据,如 STEM 图表、逻辑谜题、复杂视觉象征等数据不仅少,何况标注资本极高。

推理质地杂沓不王人:即便现存的「推理数据」也存在推理过程短、模版化,标注粒度不及、枯竭中间考证、视觉与逻辑推理割裂的问题。

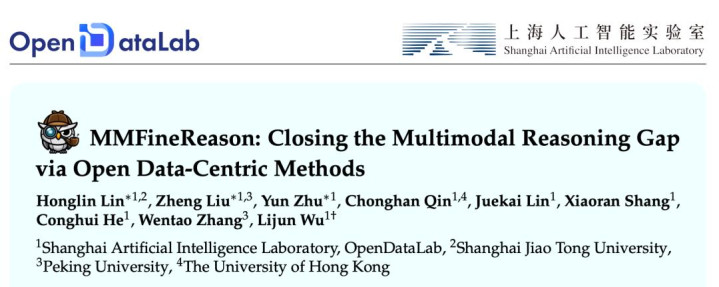

为了填补这一空缺,上海 AI 执行室 OpenDataLab 磋磨团队负责开源了 MMFineReason 框架。这既是一套全经过 100% 基于开源生态、可复现的多模态推理数据合成 Pipeline,同期也开源了由此要领构建的包含 1.8M 高质地样本、5.1B Token 的大限制数据集。

论文标题:MMFineReason: Closing the Multimodal Reasoning Gap via Open Data-Centric Methods

Huggingface 论文:https://huggingface.co/papers/2601.21821

名堂主页:https://mmfinereason.github.io/

数据集 & 模子:https://huggingface.co/collections/OpenDataArena/mmfinereason

小模子,大性能:高效数据遴选的庞杂上风

先来秀一秀性能抑遏。团队很惊喜的发现,MMFineReason 的出现,记号着多模态模子插足了「以小博大」的新阶段。

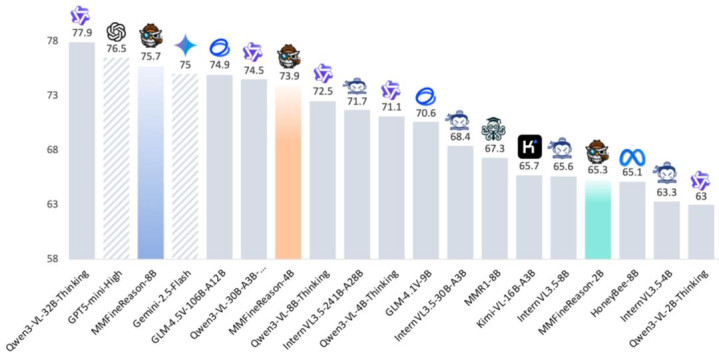

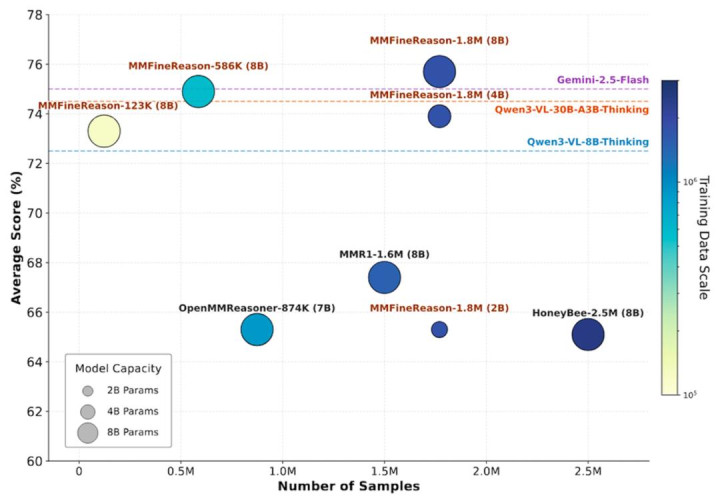

执行数据闪现,MMFineReason-4B 模子基于 Qwen3-VL-4B 锻真金不怕火而成,其推理才调不仅卓绝了 Qwen3-VL-8B-Thinking,性能更是直逼 30B 参数限制的 Qwen3-VL-30B-A3B-Thinking。

更令磋磨团队惊喜的是,通常基于同尺寸底座锻真金不怕火的 MMFineReason-8B,弘扬愈加优秀:它平直打败了 Qwen3-VL-30B-A3B-Thinking 和 Gemini-2.5-Flash,并驱动向 GPT5-mini-High 及 Qwen3-VL-32B-Thinking 等顶级模子发起冲击。

值得强调的是,这种「跨级碾压」的性能跃迁并非来悔改的模子结构蓄意,也不是通过更复杂的锻真金不怕火妙技竣事的,而确切完全源于数据层面的变化 —— 尤其是推理数据的结构化进度与单元样本中的有用推理密度。

更进一步,团队还发现通过难度感知过滤,能竣事极高的数据诊治抑遏:仅使用总量 7%(约 123K)的高难度精选子集数据,即可比好意思全量 1.8M 数据相配的性能弘扬。

因此,当数据被有用筛选、难度与模子才调精准对王人时,数据遴选本人就成为决定参数抑遏的中枢杠杆。

揭秘「Closed-Source Level」数据管线:完全开源的数据坐蓐线

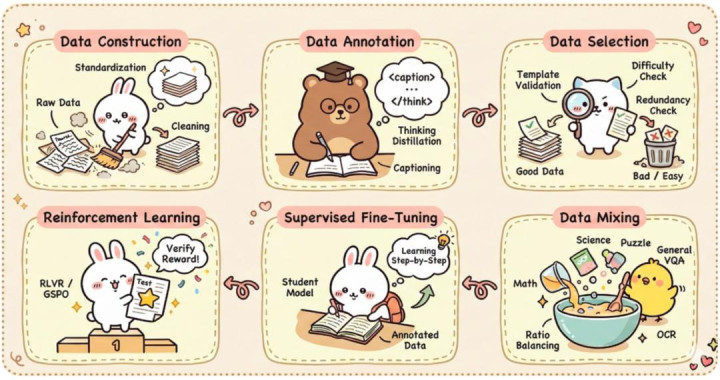

不同于依赖黑盒 API 的传统决策,MMFineReason 构建了一套完全开源的透明且高效的 Pipeline,全经过 100% 基于开源模子。所有经过主要通过三个阶段来竣事高质地数据的坐蓐:

数据要领化:当先从起源界说「什么是可推理任务」,对 STEM、Puzzle、图、几何、科学表等多领域数据进行要领化处置并长入 Schema,并进行严格的清洗。

推理蒸馏:行使 Qwen3-VL-235B-Thinking 算作淳厚模子进行推理蒸馏,并严格着力四阶段推理框架:「视觉感知 → 逻辑推导 → 中间考证 → 论断阐发」,从而来生成精通且具备「视觉落地」才调的 CoT 推理轨迹。

双重过滤:为了确保锻真金不怕火的高效性,米兰体育团队引入了双层筛选机制,第一是正确性过滤,确保谜底与推理过程严格一致;在剔除低质地 CoT 的基础上,进行难度感知(Difficulty-Aware)过滤,成心筛选出对 Qwen3-VL-4B 小模子具有高「锻真金不怕火价值」的样本,即「小模子清静失败」的样本,从而幸免了无效数据的堆砌。

最终,磋磨团队取得了 MMFineReason-1.8M(正确全量), MMFineReason-586K(正确且去掉过于苟简样本),以及 MMFineReason-123K(正确且最繁重样本)三个高质地数据集。

MMFineReason-1.8M:专为「深度推理」打造的高质地多模态数据

与其说 MMFineReason 是一个老例的 VQA 数据集,倒不如将其界说为一个专为多模态大模子准备的「硬核念念维锻真金不怕火场」。在刻下多模态领域大都堕入「数据饥渴」与「念念维链断层」的配景下,该名堂展现出了极具辨识度的中枢特征。

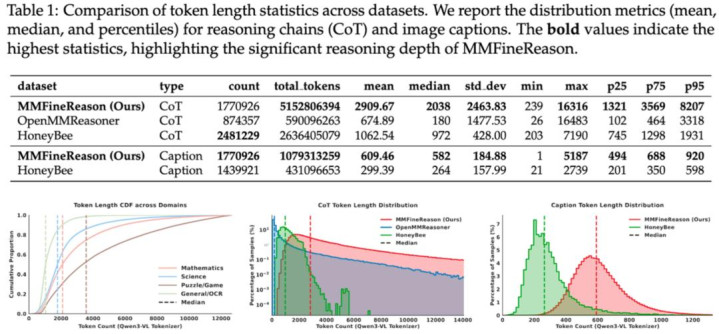

当先,MMFineReason 在念念维深度上竣事了质的飞跃。比较 HoneyBee 等同类数据集,其平均念念维链(CoT)长度达到了惊东谈主的 2,910 tokens,限制足足是前者的 2.7 倍。这种长旅途推理数据的引入,骨子上是让模子告别了苟简的「直观判断」,转而掌抓一套详备且具象的「视觉 - 逻辑」推导范式。

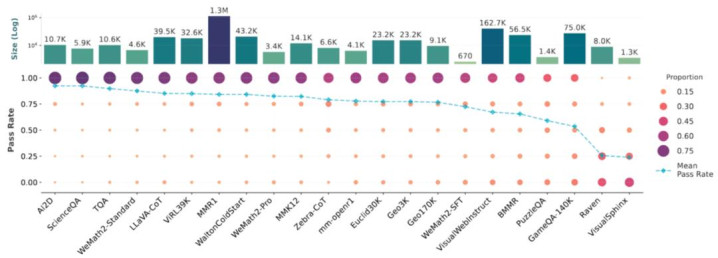

在领域辨别上,磋磨团队展现出了赫然的去平素化导向,坚定拒却易于「刷分」的苟简样本,转而深耕高难度逻辑土产货。

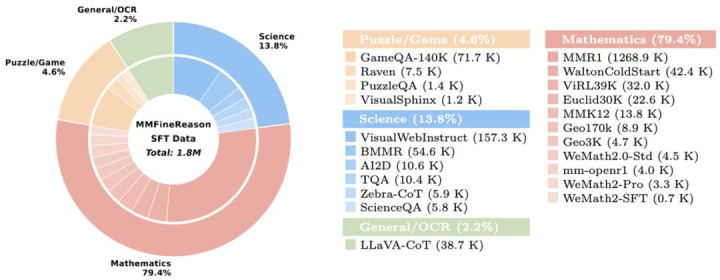

数据鸠集,数学领域以 79.4% 的全都占比强化了象征推理根基,涵盖了几何、微积分等深度学科;13.8% 的科学数据则聚焦于复杂的物理、化学图表分析;此外,数据集还引入了 4.6% 的谜题与游戏数据,通过抽象阵势识别与政策博弈,约束试探并挑战开源模子的才调上限。

{jz:field.toptypename/}

图为 MMFineReason 数据集的数据辨别情况。不错看到数据集的领域掩盖了数学、谜题与游戏、几何 / 微积分、图表与复杂科学等。

更具久了真谛的知悉在于这种高强度锻真金不怕火带来的「协同补助效应」。执行抑遏冲突了专项锻真金不怕火会消弱通用才调的固有剖析:当模子在 STEM 和逻辑难题上进行深度钻研时,其在一般性 VQA 任务上的弘扬反而取得了同步增强。这种以点带面的才调开释,再次印证了高质地逻辑链条才是驱动模子性能跨级演进的真逻辑。

结语与预测

MMFineReason 的开源,阐明了在多模态领域,当模子架构缓缓顾问、参数限制的边缘收益约束下落,决定才调差距的,不再是模子有多大,而是「数据是否果然教训模子如何推理」。通过抽象化的数据工程,小参数模子完全有后劲在复杂推理任务上叛逆以致卓绝大参数模子。

这不是一次限制的到手,而是 Data-Centric 要领论的到手。咱们期待异日在多模态开源大模子的路上,能用更高效、更高价值的数据来促进社区的跨越。

现在,该名堂已在 Huggingface 及 GitHub 全面上线,为开源社区提供了从数据到器具链的完好相沿。